多智能体共进化:通过协同演化提升大模型能力

论文原始标题:Multi-Agent Evolve: LLM Self-Improve through Co-evolution

论文作者:Authors: Yixing Chen, Yiding Wang, Siqi Zhu, Haofei Yu, Tao Feng, Muhan Zhan, Mostofa Patwary, Jiaxuan You

原始摘要:Reinforcement Learning (RL) has demonstrated significant potential in enhancing the reasoning capabilities of large language models (LLMs). However, the success of RL for LLMs heavily relies on human-curated datasets and verifiable rewards, which limit their scalability and generality. Recent Self-Play RL methods, inspired by the success of the paradigm in games and Go, aim to enhance LLM reasoning capabilities without human-annotated data. However, their methods primarily depend on a grounded environment for feedback (e.g., a Python interpreter or a game engine); extending them to general domains remains challenging. To address these challenges, we propose Multi-Agent Evolve (MAE), a framework that enables LLMs to self-evolve in solving diverse tasks, including mathematics, reasoning, and general knowledge Q&A. The core design of MAE is based on a triplet of interacting agents (Proposer, Solver, Judge) that are instantiated from a single LLM, and applies reinforcement learning to optimize their behaviors. The Proposer generates questions, the Solver attempts solutions, and the Judge evaluates both while co-evolving. Experiments on Qwen2.5-3B-Instruct demonstrate that MAE achieves an average improvement of 4.54% on multiple benchmarks. These results highlight MAE as a scalable, data-efficient method for enhancing the general reasoning abilities of LLMs with minimal reliance on human-curated supervision.

翻译标题:多智能体共进化:通过协同演化提升大模型能力

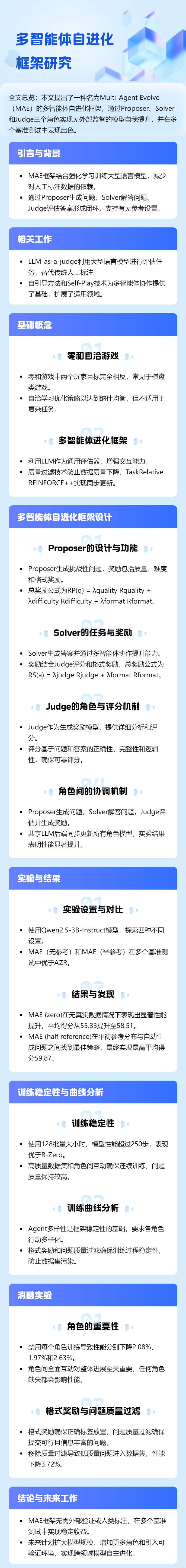

翻译摘要:强化学习(RL)在增强大型语言模型(LLMs)的推理能力方面展现出巨大潜力。然而,LLM 的 RL 成功高度依赖人工标注的数据集和可验证的奖励,这限制了其可扩展性和通用性。受游戏和围棋中该范式的启发,最近的自对弈 RL 方法旨在在不依赖人工标注数据的情况下提升 LLM 的推理能力。然而,这些方法主要依赖于反馈环境(如 Python 解释器或游戏引擎),扩展到通用领域仍具挑战。为了解决这些问题,我们提出了 Multi-Agent Evolve(MAE),这是一个框架,使 LLM 能够在解决多种任务(包括数学、推理和常识问答)中自我进化。MAE 的核心设计基于三个相互作用的智能体(命题者、解答者、裁判)从单一 LLM 中实例化,并应用强化学习优化其行为。命题者生成问题,解答者尝试解答,裁判评估两者并共同进化。在 Qwen2.5-3B-Instruct 上的实验表明,MAE 在多个基准上平均提升了 4.54%。这些结果表明,MAE 是一种可扩展、数据高效的 LLM 通用推理能力增强方法,仅需少量人工标注监督。

论文导览:

智能问答:

Q1: 这篇论文试图解决什么问题?

论文旨在回答一个核心研究问题:

能否在无需人工标注、也不依赖可验证环境(如 Python 解释器或游戏引擎)的前提下,为大型语言模型(LLM)构建一套有效的强化学习(RL)自提升框架,使其在通用领域(数学、推理、常识问答等)上持续进化?

为此,作者提出 Multi-Agent Evolve(MAE),通过“命题者–解答者–裁判”三元组的多智能体协同与对抗,完全利用模型自身信号完成训练,摆脱对人工 curated 数据或可验证奖励的依赖,实现数据高效、可扩展的通用推理能力自提升。

Q2: 有哪些相关研究?

相关研究可归纳为三条主线,均围绕“如何让大模型在缺乏人工标注的情况下自我提升”展开:

LLM-as-a-Judge

核心思想:用同一个大模型充当裁判,为生成内容打分或排序,替代昂贵人工标注。

代表工作:

– Gu et al., 2024 综述了“LLM-as-a-judge”在评估、对齐、检索等场景的应用。

– Yuan et al., 2025 提出 Self-Rewarding Language Models,让模型自评分数并迭代优化指令遵循能力。

– Pang et al., 2023 通过“师生”自博弈,用自评信号提升推理准确率。

Self-Play for LLM

核心思想:双智能体零和博弈,无需外部数据即可生成训练信号。

代表工作:

– Absolute Zero(Zhao et al., 2025)在代码、数学任务中利用 Python 解释器提供可验证奖励,实现零数据 RL。

– SPIRAL(Liu et al., 2025a)在零和博弈框架下进行多轮对抗,激励推理能力。

– Self-RedTeam(Liu et al., 2025b)用攻击-防守博弈提升模型安全性。

与 MAE 的区别:上述方法依赖可验证环境或严格零和设定,难以泛化到通用开放领域。

Multi-Agent LLM 系统

核心思想:将大模型实例化为多个专用智能体,通过协作或竞争完成复杂任务。

代表工作:

– AgentVerse(Chen et al., 2023)探索多智能体协作涌现行为,但未对模型参数进行训练。

– MALT(Motwani et al., 2025)引入投票机制对多智能体进行训练,提升推理能力。

– AutoDefense(Zeng et al., 2024)用多智能体攻防对抗抵御越狱攻击。

与 MAE 的区别:多数工作仅把多智能体当作推理阶段工具,未形成“生成–解答–评判”闭环的自进化训练框架。

综上,MAE 在以下方面实现突破:

把“LLM-as-a-Judge”从静态评估工具升级为可训练的智能体,与命题者、解答者同步更新;

把“Self-Play”从零和、可验证环境扩展到通用领域,引入非零和、多角色协同的共进化机制;

把“Multi-Agent LLM”从推理阶段协作推进到训练阶段强化学习,实现完全无人工标注的自提升循环。

Q3: 论文如何解决这个问题?

论文提出 Multi-Agent Evolve(MAE) 框架,将“命题–求解–评判”全流程封装为可训练的多智能体闭环,用自身生成的通用域奖励信号替代人工标注与可验证环境,具体解法分为四步:

三元角色协同

同一基座 LLM 被实例化为三个互斥又互补的策略网络:

Proposer:生成问题,目标为“高质量+高挑战”。

Solver:给出答案,目标为“正确且格式合规”。

Judge:充当可训练的生成式奖励模型,输出 1–10 分,无需外部真值。

域无关奖励设计

每个角色的损失函数仅依赖 Judge 的分数与可解析性,彻底摆脱外部标注:

Proposer 总奖励 R_P = 1/3 R_quality + 1/3 (1 - R_S(q)) + 1/3 R_format 其中 R_S(q) 为 Solver 在 q 上的平均得分,难度越高 Proposer 越受益。

Solver 总奖励 R_S = 0.5 V_J(a,q) + 0.5 R_format

Judge 总奖励 R_J = R_format 仅鼓励输出可解析的

质量过滤与格式约束

每次生成的题目需经 Judge 评估,质量分≥0.7 才进入题库,防止“垃圾进-垃圾出”。

对三方输出均施加格式奖励,确保

同步共进化训练

采用 Task-Relative REINFORCE++:

为每个角色单独估计优势 A_norm_role = (r - μ_role)/σ_role,降低方差。

每步收集三元组经验后,一次性同步更新共享骨干参数,使命题难度与解答能力始终匹配,形成“越来越难–越解越强”的飞轮。

通过上述设计,MAE 在零人工标注、零可验证环境的条件下,仅用 16 条自生成种子题目即可启动,在 250 步内持续自我进化,平均提升 4.54%,显著优于 AZR 与 SFT 基线。

Q4: 论文做了哪些实验?

论文在 Qwen2.5-3B-Instruct 基座上系统验证了 MAE 的有效性、稳定性与可扩展性,实验分四大组:

零种子 vs 有种子对比

MAE(zero):仅 16 条自生成题目启动,无任何真实数据。

MAE(no reference):967 条真实题目做初始题库,后续全自生成。

MAE(half reference):50% 概率参考真实题、50% 自生成。

MAE(with reference):100% 基于真实题改写。

对照基线:Base、AZR(同样零数据)、SFT(用 967 题+真值微调)。

覆盖 26 个基准

数学:GSM8K、MATH、AMC、Minerva、Olympiad

代码:HumanEval+、MBPP+

常识推理:ARC-c、MMLU、CQA、OBQA、BoolQ、HellaSwag

阅读理解:SQuAD、NaturalQuestions、TriviaQA

分布外:TruthfulQA、BBH、LiveBench、Winogrande、MMLU-Pro 等

指标:统一用强 LLM-as-a-judge 提取

训练过程诊断

题库规模曲线:验证质量过滤后有效题目持续净增,未出现崩塌。

难度曲线:Proposer 生成的题目平均 solve-score 稳定在 0.4–0.6,符合“desirable difficulty”。

整体准确率:随训练步单调上升,250 步后仍无过拟合或平台迹象。

消融与鲁棒

角色消融:分别冻结 Proposer/Solver/Judge 训练,性能下降 1.97–2.63%,证明三角共生缺一不可。

机制消融:

– 去掉质量过滤 → 低质量题目污染题库,Overall 掉 3.72%。

– 去掉格式奖励 → 解析失败率升高,但质量过滤部分代偿,Overall 仅掉 0.43%。

– 二者同时移除 → 训练 50 步后即出现标签错乱,无法持续。

主要结果一览(Overall 平均准确率)

零数据赛道:Base 55.33 → AZR 57.72 → MAE(zero) 58.51

有数据赛道:SFT 53.87 → MAE(with ref) 57.11 → MAE(half ref) 59.87(最佳)

实验结论:MAE 在完全无人工标注、无可验证环境的条件下仍能稳定提升,且随参考题目引入增益进一步放大,验证了多角色共进化与自奖励机制在通用领域的可扩展性。

Q5: 有什么可以进一步探索的点?

以下方向可进一步拓展 MAE 的边界与深度:

规模与模型维度

将框架迁移至 7B、30B、70B 乃至 MoE 结构,观察多角色共进化是否随规模出现突现能力或收敛速度质变。

研究参数高效微调(QLoRA、GaLore)对三角色同步更新的影响,降低大模型训练成本。

角色与拓扑扩展

引入“Reflector”角色对 Judge 的评分进行元反思,形成双层级裁判,减少评分偏差。

让多个 Proposer/Solver 种群并行演化,采用 Elo 或联赛机制定期淘汰,提升探索多样性。

将拓扑从线性“命题–求解–评判”扩展为图结构,支持多轮辩论或协作式证明。

奖励设计与可验证环境融合

对数学、代码子集接入 Python、Lean4 等可验证器,构建“混合奖励”:可验证题用符号奖励,开放题用 Judge 奖励,实现统一平台。

引入基于不确定性的自适应权重 λ_verify(t),动态调节可验证信号与 Judge 信号的比例。

多模态与长程任务

把命题空间扩展至图文混合(几何题、图表推理),验证 Judge 是否能跨模态给出稳定分数。

生成长程规划任务(24 点、迷宫、Minecraft 目标),检验框架在稀疏奖励环境下的稳定性。

理论分析

证明/证伪三角色协同是否收敛至某种“广义纳什均衡”,并给出收敛速率与超参数的关系。

研究难度奖励 1−R_S(q) 的上界,防止 Proposer 生成不可解问题导致训练崩溃。

安全与对齐

在 Red-Team 场景下增加“攻击者”角色,与 Defender、Judge 形成三方博弈,检验框架能否在对抗中提升安全性。

引入宪法约束或人类偏好正则项,确保进化过程中不出现误导性、偏见性题目。

数据与评测

构建“MAE-Elo”排行榜:不同基座模型用同一协议自进化,公平比较自提升潜力。

开源进化题库与 Judge 打分语料,供社区研究自生成数据的质量、偏差与可迁移性。

系统与工程优化

设计异步流水线,让 Proposer、Solver、Judge 在不同设备并行,提升经验产出效率。

探索梯度压缩、局部更新等分布式策略,支持千亿级模型在无人工标注场景下的持续预训练。

Q6: 总结一下论文的主要内容

Multi-Agent Evolve (MAE) 提出一种无需人工标注、无需可验证环境的强化学习框架,让大模型通过“自命题–自解答–自评判”三元角色协同实现通用域自我进化。核心贡献与结果如下:

框架

同一基座 LLM 同时扮演 Proposer(出题)、Solver(答题)、Judge(打分),形成闭环。

采用 Task-Relative REINFORCE++ 对三角色同步更新,仅用 Judge 的 1–10 分信号与格式奖励驱动训练,彻底摆脱外部真值。

奖励机制

Proposer:质量分 + 难度分(1 − Solver 平均分)+ 格式分,鼓励“高质量且具挑战”的题目。

Solver:Judge 打分 + 格式分,鼓励“正确且易解析”的答案。

Judge:仅受格式奖励约束,保证

质量过滤

题目需获 Judge ≥0.7 才被收入题库,防止低质或不可解数据污染。

实验

在 Qwen2.5-3B-Instruct 上,零数据启动(16 条自生成种子)即把 Overall 准确率从 55.33→58.51,超越 AZR。

加入 967 条无真值参考题后,MAE(half reference) 进一步提升至 59.87%,显著优于 SFT(53.87%)。

覆盖 26 个基准(数学、代码、常识、阅读、OOD),普遍增益;250 步训练曲线稳定,题库规模与题目难度同步增长。

消融

冻结任一角色或移除质量过滤,性能下降 1.97–3.72%,验证三角共生与数据自净的必要性。

综上,MAE 首次在通用领域实现完全自驱动的多智能体共进化,为“无标注、无验证器”场景下的 LLM 自提升提供了可扩展范式。

阅读全文 →

来源:Arxiv2025-10-27 17:58:02 UTC