智能体组织的新时代:与语言模型一起学习组织

论文原始标题:The Era of Agentic Organization: Learning to Organize with Language Models

论文作者:Authors: Zewen Chi, Li Dong, Qingxiu Dong, Yaru Hao, Xun Wu, Shaohan Huang, Furu Wei

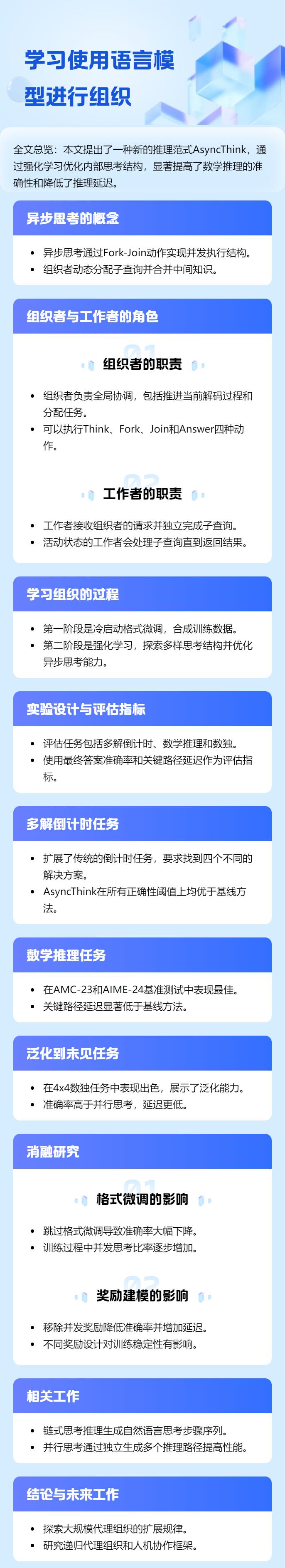

原始摘要:We envision a new era of AI, termed agentic organization, where agents solve complex problems by working collaboratively and concurrently, enabling outcomes beyond individual intelligence. To realize this vision, we introduce asynchronous thinking (AsyncThink) as a new paradigm of reasoning with large language models, which organizes the internal thinking process into concurrently executable structures. Specifically, we propose a thinking protocol where an organizer dynamically assigns sub-queries to workers, merges intermediate knowledge, and produces coherent solutions. More importantly, the thinking structure in this protocol can be further optimized through reinforcement learning. Experiments demonstrate that AsyncThink achieves 28% lower inference latency compared to parallel thinking while improving accuracy on mathematical reasoning. Moreover, AsyncThink generalizes its learned asynchronous thinking capabilities, effectively tackling unseen tasks without additional training.

翻译标题:智能体组织的新时代:与语言模型一起学习组织

翻译摘要:我们设想了一个新的AI时代,称为智能体组织,其中智能体通过协作和并发工作来解决复杂问题,从而实现超越个体智能的成果。为了实现这一愿景,我们引入了异步思维(AsyncThink)作为大语言模型推理的新范式,将内部推理过程组织成可并发执行的结构。具体而言,我们提出了一种思维协议,其中组织者动态分配子查询给工作者,合并中间知识,并生成连贯的解决方案。更重要的是,该协议中的思维结构可以通过强化学习进一步优化。实验表明,AsyncThink在数学推理准确率提高的同时,推理延迟比并行思维降低了28%。此外,AsyncThink可以将其学习到的异步思维能力泛化到未见过的任务,而无需额外训练。

论文导览:

智能问答:

Q1: 这篇论文试图解决什么问题?

论文旨在解决“如何令多个大语言模型智能体以并发且协作的方式完成复杂推理”这一核心问题,具体可分解为以下三点:

克服并行推理的延迟瓶颈

现有并行思维方法先生成多条独立推理轨迹再聚合,受最慢轨迹与聚合开销双重制约,导致端到端延迟居高不下。

摆脱手工设计固定流程的局限

静态流程无法根据查询特点动态选择“分而治之”或“步步推进”等策略,缺乏对任务多样性的适应性。

实现可学习的组织策略

人工枚举所有可能推理结构不可行,需要一种可训练的机制,让模型自己学会何时拆分子问题、如何调度并发工人、何时合并中间结果。

为此,作者提出“异步思维(AsyncThink)”范式,将推理过程抽象为Fork-Join 图,由同一 LLM 扮演 Organizer(负责动态拆分与合并)与 Worker(并发执行子查询),并通过强化学习直接优化该图结构,从而在降低 28% 推理延迟的同时提升数学推理准确率,且具备零样本迁移到未见任务的能力。

Q2: 有哪些相关研究?

论文在第 5 节系统回顾了相关研究,可归纳为三大主线:

链式/可验证强化推理

Chain-of-Thought (CoT) 及其 RL 微调:Wei et al. 2022;DeepSeek-R1、Kimi K2 等利用可验证奖励(RLVR)扩展推理长度。

奖励模型与策略优化:CompassVerifier、Reasoning Reward Model、VAPO、TAPERED-off-policy 等探索更稳健的策略梯度方法。

并行/树状思维与测试时扩展

多路径独立采样:Tree-of-Thoughts、LLM-Monkey、ParaThinker、Parallel-R1 等通过多数投票或学习式聚合提升准确率。

并行解码架构:Hogwild!-Inference、Multiverse、Group-Think 等修改注意力或调度层以实现 token/分支级并发。

多智能体协作系统

静态角色系统:MetaGPT、AutoGen、CAMEL 等用预定义对话模板实现协作。

动态/演化协作:ProAgent、Puppeteer、Self-Evolving Agents 等引入 RL 或信念更新让角色自适应;Zahedifar 等提出中央控制器调度。

AsyncThink 与上述工作的核心差异在于:

将“如何组织并发推理”本身建模为可学习的 Fork-Join 策略,而非手工流程或独立路径投票;

用同一 LLM 权重同时扮演 Organizer 与 Worker,通过纯文本动作标签完成动态拆分-合并,无需修改模型架构;

采用**组相对策略优化(GRPO)**直接对非序列化轨迹进行强化学习,兼顾答案正确性与关键路径延迟。

Q3: 论文如何解决这个问题?

论文将“让大模型学会组织并发协作推理”形式化为一个可学习的策略优化问题,并通过“异步思维(AsyncThink)”框架分三步解决:

形式化:提出 Organizer–Worker Fork-Join 协议

同一 LLM 以纯文本标签

推理轨迹被抽象成有向无环图,其关键路径长度即为理论延迟下界。

两阶段训练:先语法后策略

冷启动格式微调:用 GPT-4o 合成 25 k∼43 k 条符合 Fork-Join 语法的轨迹,仅让模型学会“合法出牌”。

强化学习微调:

奖励函数 = 答案正确度 + 格式合规度 + 并发利用率

R= RFE(格式错误则固定惩罚), R= RA + λRη(否则)

其中并发奖励 Rη=min(η/c,τ)/τ,η=1/T∑Tt=1 a_t 鼓励工人池满负荷。

采用扩展的 GRPO,把 Organizer 与所有 Worker 轨迹视为同一 episode,共享组相对优势,实现非序列化策略梯度更新。

推理:零样本动态组织

训练后的模型在测试时自动决定:

何时 Fork(拆出何种子查询);

多少 Worker 并发(受池容量 c 限制);

何时 Join(同步并继续 Fork 下一轮)。

实验表明,该方案在数学、倒计时、数独等任务上同时提升准确率并降低 28% 关键路径延迟,且仅在简单倒计时数据上训练即可零样本泛化到图论、遗传学等全新领域。

Q4: 论文做了哪些实验?

论文围绕「准确率–延迟」双指标,在 3 类任务、5 组对比、4 项消融与 2 个零样本泛化案例上系统评估 AsyncThink,关键实验如下:

主任务评测

Multi-Solution Countdown(MCD)

– 400 例「找 4 条不同表达式」;Agent 池容量 c=2。

– 指标:≥k Correct(k=1,2,3,4)与关键路径延迟。

– 结果:All-Correct 89.0%,比并行/顺序基线分别↑20.4% 与↑18.5%,延迟 4.5k tokens 级。

数学推理 AMC-23 & AIME-24

– c=4,Worker 单轮 512 tokens。

– 结果:AIME-24 准确率 38.7%,与并行思维最佳持平,但延迟 1468 步,较并行思维 2048 步↓28%。

4×4 Sudoku(零样本)

– 仅用 MCD 训练,直接测 400 例 Enigmata 数独。

– 结果:准确率 89.4%,显著高于并行思维 84.2%,延迟 2853 步,低于并行 3694 步。

消融实验(表 3)

去掉并发奖励 Rη:准确率↓3–4%,延迟↑37–32%。

去掉冷启动格式微调:模型仅能顺序 Fork-Join,并发比锁定 1/c,准确率跌至 54–65%。

去掉 RL(仅用 SFT):几乎无法产出正确答案(准确率≈0–4%)。

训练动态分析(图 6)

180 步 RL 内,准确率由 0→89%,并发比由 49%→65%,Fork 次数由 0.9→1.4,延迟先升后降,表明模型自主学到“先深后广”再“压缩”策略。

准确率–延迟前沿(图 7)

固定 Organizer 预算,仅调 Worker 长度,AsyncThink 整条 Pareto frontier 位于并行/顺序上方,同准确率下延迟平均↓28%。

案例可视化

图 8:MCD 四阶段 Fork-Join,逐步凑齐 4 条表达式。

图 9:几何题同时 Fork 3 条坐标/向量/归一化路径,Join 后一致得 cosθ=1/3。

图 10–11:零样本泛化至图论最小顶点覆盖与遗传学杂交比例推断,均正确调用 Fork-Join。

综上,实验覆盖合成、竞赛数学、逻辑谜题与跨域泛化,一致显示 AsyncThink 在更高准确率的同时实现更低理论延迟,且组织策略可迁移至未见任务。

Q5: 有什么可以进一步探索的点?

可进一步探索的方向可归纳为“规模-递归-人机”三大维度及若干技术细节:

规模维度(Scaling Agentic Organization)

数量扩展:研究异步思维的 scaling law——当 Worker 数量从数十增至数百甚至上千时,准确率-延迟-成本曲线的拐点与饱和行为。

异构专家:打破“同权重”设定,引入数学、代码、检索等不同专家模型或外挂工具(代码解释器、数据库、Web API),让 Organizer 学会“选工具+派任务”的联合策略。

递归维度(Recursive Agentic Organization)

动态晋升:任一 Worker 可在中途被提升为 sub-Organizer,继续 Fork 自己的子团队,形成多级嵌套 DAG,适应“证明-引理-子引理”式深层分解。

层次调度:顶层仅负责粗粒度分解,底层负责细粒度推理,研究跨层通信与梯度传播机制,避免信用分配稀疏。

人机协同维度(Human-AI Agentic Organization)

Human-as-Organizer:人类用自然语言

Human-as-Worker:模型主动把需人类判断(伦理、事实核查、创意评估)的步骤 Fork 给真实用户,Join 后继续推理,实现混合智能。

共设计接口:执行前让人类与 AI 共同商定 Fork-Join 策略,形成“可编辑的推理蓝图”。

奖励与优化

细粒度奖励:引入中间步骤可验证奖励(如子查询答案正确性、逻辑一致性),缓解仅最终答案稀疏奖励问题。

延迟精确建模:在奖励中显式计入真实通信开销(序列化、网络延迟),而非仅用 token-level 关键路径。

多目标 RL:把准确率、延迟、成本、碳排放等作为 Pareto 优化目标,学习可调节 frontier 的策略族。

结构与理论

最优 DAG 生成:研究异步思维轨迹与动态规划、并行调度理论的映射,给出近似最优 Fork-Join 策略的可证明边界。

可解释组织:可视化并量化 Organizer 何时/为何 Fork,提供人类可读的“推理组织图”,支持调试与信任评估。

安全与鲁棒

错误级联控制:防止单 Worker 错误通过 Join 放大,研究回滚或多数表决机制。

恶意子查询检测:避免 Organizer 被诱导生成危险或违规内容,需嵌入对齐过滤模块。

跨模态与实时场景

多模态 Fork:处理文本-图像-音频混合子任务, Organizer 需决定模态专属 Worker 的调度。

流式推理:对实时输入(视频流、对话流)实现增量式 Fork-Join,平衡延迟与准确率。

探索上述方向可推动“agentic organization”从实验室推理任务走向大规模、多层次、人机混合的复杂生产系统。

Q6: 总结一下论文的主要内容

论文提出“异步思维(AsyncThink)”范式,让同一 LLM 学会把复杂推理拆成可并发执行的 Fork-Join 图,通过强化学习同时优化答案正确性与关键路径延迟,实现“多智能体级协作”却无需修改模型架构。主要贡献与结果如下:

新范式:Organizer-Worker 纯文本协议,用

两阶段训练:冷启动格式微调 → GRPO 强化学习,奖励 = 正确度 + 格式合规 + 并发利用率。

实验效果:

– 多解倒计时 All-Correct 89.0%,超并行思维 20.4%,延迟相当。

– AIME-24 / AMC-23 准确率 38.7% / 73.3%,与最佳并行方法持平,延迟↓28%。

– 零样本迁移至 4×4 数独准确率 89.4%,继续领先且延迟更低。

消融与曲线:并发奖励、格式微调、RL 均不可或缺;AsyncThink 整条准确率-延迟 Pareto 前沿全面占优。

综上,AsyncThink 首次让大模型以内生、可训练的方式学会“何时并行、如何合并”,在提升推理质量的同时显著压缩理论延迟,并具备跨任务泛化能力。

阅读全文 →

来源:Arxiv2025-10-30 16:25:10 UTC