EdgeRunner 20B:在边缘设备上实现与 GPT-5 相同的军事任务能力

论文原始标题:EdgeRunner 20B: Military Task Parity with GPT-5 while Running on the Edge

论文作者:Authors: Jack FitzGerald, Aristotelis Lazaridis, Dylan Bates, Aman Sharma, Jonnathan Castillo, Yousif Azami, Sean Bailey, Jeremy Cao, Peter Damianov, Kevin de Haan, Luke Kerbs, Vincent Lu, Joseph Madigan, Jeremy McLaurin, Jonathan Tainer, Dave Anderson, Jonathan Beck, Jamie Cuticello, Colton Malkerson, Tyler Saltsman

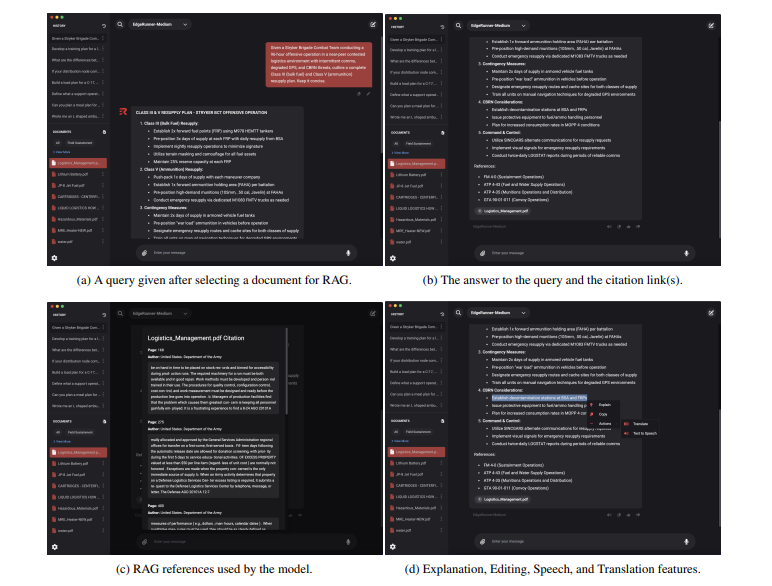

原始摘要:We present EdgeRunner 20B, a fine-tuned version of gpt-oss-20b optimized for military tasks. EdgeRunner 20B was trained on 1.6M high-quality records curated from military documentation and websites. We also present four new tests sets: (a) combat arms, (b) combat medic, (c) cyber operations, and (d) mil-bench-5k (general military knowledge). On these military test sets, EdgeRunner 20B matches or exceeds GPT-5 task performance with 95%+ statistical significance, except for the high reasoning setting on the combat medic test set and the low reasoning setting on the mil-bench-5k test set. Versus gpt-oss-20b, there is no statistically-significant regression on general-purpose benchmarks like ARC-C, GPQA Diamond, GSM8k, IFEval, MMLU Pro, or TruthfulQA, except for GSM8k in the low reasoning setting. We also present analyses on hyperparameter settings, cost, and throughput. These findings show that small, locally-hosted models are ideal solutions for data-sensitive operations such as in the military domain, allowing for deployment in air-gapped edge devices.

翻译标题:EdgeRunner 20B:在边缘设备上实现与 GPT-5 相同的军事任务能力

翻译摘要:我们介绍了 EdgeRunner 20B,这是一个针对军事任务优化的 gpt-oss-20b 的微调版本。EdgeRunner 20B 在从军事文档和网站中整理的 160 万条高质量记录上进行训练。我们还介绍了四个新的测试集:(a) 战斗部队,(b) 战地医疗兵,(c) 网络作战,(d) mil-bench-5k(一般军事知识)。在这些军事测试集上,EdgeRunner 20B 在 95% 以上的统计显著性下达到了或超过了 GPT-5 的任务性能,除了战斗医疗兵测试集的高推理设置和 mil-bench-5k 测试集的低推理设置。与 gpt-oss-20b 相比,在 ARC-C、GPQA Diamond、GSM8k、IFEval、MMLU Pro 或 TruthfulQA 等通用基准测试中,没有统计显著的性能下降,除了 GSM8k 的低推理设置。我们还分析了超参数设置、成本和吞吐量。这些发现表明,小型、本地托管模型是数据敏感操作(如军事领域)的理想解决方案,允许在空气隔离的边缘设备上部署。

论文导览:

智能问答:

Q1: 这篇论文试图解决什么问题?

论文旨在证明:在军事这一高敏感、高可靠性需求的垂直场景里,参数规模仅 20B、完全本地部署的专用大模型可以在核心任务上达到与云端旗舰模型 GPT-5 相当的精度,同时满足

物理隔离(air-gapped)

零持续调用成本

边缘设备实时推理

三大刚性约束,从而解决“云端大模型在战时或保密环境下不可用时,作战人员仍能获得同等 AI 能力”的问题。

Q2: 有哪些相关研究?

与 EdgeRunner 20B 直接相关的研究可归纳为三类:

军事领域专用评测与模型

TRACLM(Ruiz & Sell, 2024)

提出 MilBench / MilGLUE 军事任务套件,并在未分类陆军文档上微调开源模型,是首批公开报道的“军用 LLM”工作。

JointStaffBench(Parham & Lynn, 2025)

聚焦 Joint Publication 知识问答,数据集仅限军方内部,与本文的 mil-bench-5k 互为补充。

边缘/本地部署的大模型研究

llama.cpp(ggerganov, 2025)

提供纯 C/C++ 推理框架,使 20B 级别模型在笔记本级硬件实时运行,为本文吞吐量实验提供基线。

MXFP4 量化与 TensorRT-Model-Optimizer(Nvidia, 2025)

实现 4-bit 专家层权重量化,在保持精度的同时把显存压到消费级 GPU 可承受范围,被 EdgeRunner 直接采用。

领域自适应微调与数据合成

合成 QA 流水线(本文 3.1 节)

受 Alpaca、Self-Instruct 等启发,但针对军事文档增加了“多阶段质量过滤 + 教义一致性检查”,与通用领域的合成方法形成对比。

量化感知训练 vs. 后训练量化

本文实验验证了“bf16 训练 → MXFP4 后量化”在 20B 规模上足以避免 QAT 的额外复杂度,补充了量化文献在军事场景的空白。

以上研究共同构成了“把云端级能力搬到密封边缘环境”这一问题的技术与评测基础,EdgeRunner 20B 在此基础上首次给出了与 GPT-5 统计持平的实证结果。

Q3: 论文如何解决这个问题?

论文通过“数据-训练-评测-部署”四位一体的闭环,把“云端级能力”压缩到 20B 参数的本地模型,具体路径如下:

构建 1.6 M 高质量军事指令数据

多阶段合成流水线:文档→摘要→QA 对→质量评审(PASS/FIX/FAIL),全程用领域提示保证“教义级”精度。

严格去污染:与后续评测集做精确+模糊匹配,杜绝数据泄露。

精细微调策略

低学习率 1×10−6 + 大全局批次 4.2–6.3 M token,保证知识注入同时不破坏通用能力。

5–10 epoch 为甜点区;采用 Alpaca 模板小幅提升军事任务表现。

拒绝“合成思维链”:仅做知识注入,避免复杂推理轨迹反而降低准确率。

建立四类军事评测集(Gold/Silver)

覆盖 Combat-Arms、Combat-Medic、Cyber、Mil-Bench-5K,全部由现役军官或网络战专家标注,确保战场真实性。

使用 W8A8 量化的 Llama-3.3-70B 裁判模型,自动给出 C/P/I 等级,解决自由回答评分难题。

边缘部署与成本论证

训练后 MXFP4 量化 → 单卡 RTX 5090 即可 262 token/s 生成,速度反超 GPT-5 API。

一次性硬件投入后“零增量成本”,对比云端四种场景(订阅、按量、Agent、7×24 监控)每年可节省 $240–14 454/人。

通过上述步骤,论文在统计意义上使 EdgeRunner 20B 在 12/14 军事测试设置下达到或超越 GPT-5,同时保持通用基准无显著回退,从而解决了“战时/保密场景无法依赖云端大模型”的核心问题。

Q4: 论文做了哪些实验?

论文共执行三类实验,覆盖“微调效果-通用能力-系统效率”全链路,具体设置与结果如下:

军事任务精度对比(主实验)

数据集:COMBAT-ARMS / COMBAT-MEDIC / CYBER / MIL-BENCH-5K

对照:GPT-5 低/中/高三种推理强度

指标:相对误差 ↓ 与 p 值(α=0.05)

结论:EdgeRunner 20B 在 12/14 设置下显著优于或持平 GPT-5,仅 COMBAT-MEDIC 高推理、MIL-BENCH-5K 低推理两次略逊。

通用基准回退检验

数据集:ARC-C、GPQA Diamond、GSM8k、IFEval、MMLU-Pro、TruthfulQA

方法:与基础模型 gpt-oss-20b 对比绝对分数

结论:除 GSM8k 低推理外,其余 17/18 设置无统计显著回退,证明 specialization 未牺牲通用能力。

超参数与训练消融

40 组全量微调运行,变量含

– 学习率 {1e-6, 5e-6, 1e-5}

– 全局批次 {256, 1024, 1536} 条样本→4k 长度

– epoch {1, 8, 10}

– 聊天模板 {gpt-oss-20b, alpaca}

– 是否注入合成思维链

监控指标:四军事任务相对 ER20B 基准误差

关键发现:

大批次 + 低 LR 显著降低误差

Alpaca 模板平均提升 3–7%

合成思维链一致导致负迁移

成本与吞吐量实测

成本模型:按官方 API 价 1.25/10⁶inputtoken、10/10⁶ output token 计算四种用例的年费

吞吐量:llama.cpp + RTX 5090/MacBook Pro/MacBook Air 实测 prompt/gen 速度,与 Artificial Analysis 公布的 GPT-5 API 数据对比

结果:边缘硬件在生成速度上最高反超 GPT-5 API 69%,且零后续调用成本。

以上实验共同验证了“20B 边缘模型可在军事核心任务上替代云端 GPT-5”这一中心假设。

Q5: 有什么可以进一步探索的点?

以下方向可在此基础上继续深入,均围绕“让边缘军事模型更小、更稳、更可信”展开:

模型规模极限压缩

探索 0.5–3B 参数的专用模型能否通过稀疏化、MoE 或 Block-wise 量化在战场手持终端上保持≥90% 的 20B 精度。

研究动态推理深度(early-exit)(Hassid et al., 2025)在战术电台等电池受限场景下的能耗-精度 trade-off。

多模态战场感知

将战术地图、无人机视频、红外图像与文本指令融合,构建支持“视觉-语言-导航”三模态的边缘模型;需同步解决图像脱敏与空口带宽限制。

对抗鲁棒性与红队评测

建立面向军事的对抗提示库(GPS 欺骗、敌台干扰语义、伪造命令等),测量模型在指令注入与误导下的失效阈值。

引入“任务关键拒绝率”指标:当请求涉及交战规则边缘时,模型拒绝/执行的比例及其后果评估。

持续学习而不遗忘

研究联邦-蒸馏方案:前线单位利用本地新任务日志进行增量训练,仅回传梯度摘要到后方,既避免数据泄露又缓解灾难性遗忘。

量化参数重要性掩码,实现“战时热补丁”——在前线 30 分钟内完成一次小批量微调并立即生效。

低资源语言与方言

现代战场常伴随多国联军与当地居民,需把阿拉伯语、普什图语等低资源语言纳入指令集,考察 20B 模型在不增加显存前提下的跨语言迁移能力。

硬件-软件协同优化

与国防专用 FPGA/SoC 团队联合设计 INT4 矩阵-向量核,将 20B 模型功耗压至<15 W,满足单兵可穿戴需求。

探索片上非易失存储(MRAM)存内计算,降低断电后模型重载时间,提升阵地快速重启能力。

伦理、法律与可解释性

建立符合《武装冲突法》的可解释输出模板:每条杀伤链建议必须附带规则条文引用与置信度,供指挥官审计。

研究“人在回路”强化学习奖励函数,使模型在遵守交战规则的前提下最大化任务成功率,避免过度保守或过度激进。

实战演习验证

在年度联合演习(如 JRTC、NTC)中嵌入 EdgeRunner 作为参谋助手,记录真实指挥所环境下的决策延迟、误报率与官兵信任度,形成闭环改进数据。

以上方向若取得突破,可进一步把“云端 GPT-5 级能力”压缩到战术级边缘节点,实现真正意义上的“AI 单兵化”。

Q6: 总结一下论文的主要内容

EdgeRunner 20B:把 GPT-5 级军事能力装进 20B 边缘模型

问题

战时/保密场景下,云端大模型因链路中断或数据分级无法使用,需要可在本地、离线、消费级硬件运行的同等能力模型。

方案

以 gpt-oss-20B 为基座,用 1.6 M 自研军事指令数据低秩微调;数据经“文档→摘要→QA→质量评审”三级流水线生成,并由现役军官逐条核验。

训练关键:lr 1×10⁻⁶、大批次 4–6 M token、5–10 epoch、Alpaca 模板;拒绝合成思维链,专注知识注入。

训练后 MXFP4 量化,单卡 RTX 5090 可达 262 token/s,速度反超 GPT-5 API。

实验

新构建 4 套军事评测(Combat-Arms、Combat-Medic、Cyber、Mil-Bench-5K),含 5k+ 自由问答题,由 Llama-3.3-70B 裁判。

EdgeRunner 20B 在 12/14 设置下显著优于或持平 GPT-5(p<0.05),仅 2 项略逊。

6 项通用基准(ARC-C、GPQA、GSM8k 等)无显著回退,除 GSM8k 低推理外均保持原基座水平。

40 组超参消融:大批次+低 lr+Alpaca 模板最优;合成思维链一致负迁移。

成本:边缘模型一次性硬件投入后零增量费用;同等用量云端年费 $240–14 454/人。

结论

20B 参数、本地部署的专用模型首次在统计意义上达到云端旗舰 GPT-5 的军事任务精度,同时满足空隔离线、实时响应、零持续成本三大刚性需求,为战时与保密场景提供了可落地的 AI 解决方案。

阅读全文 →

来源:Arxiv2025-10-30 14:43:26 UTC